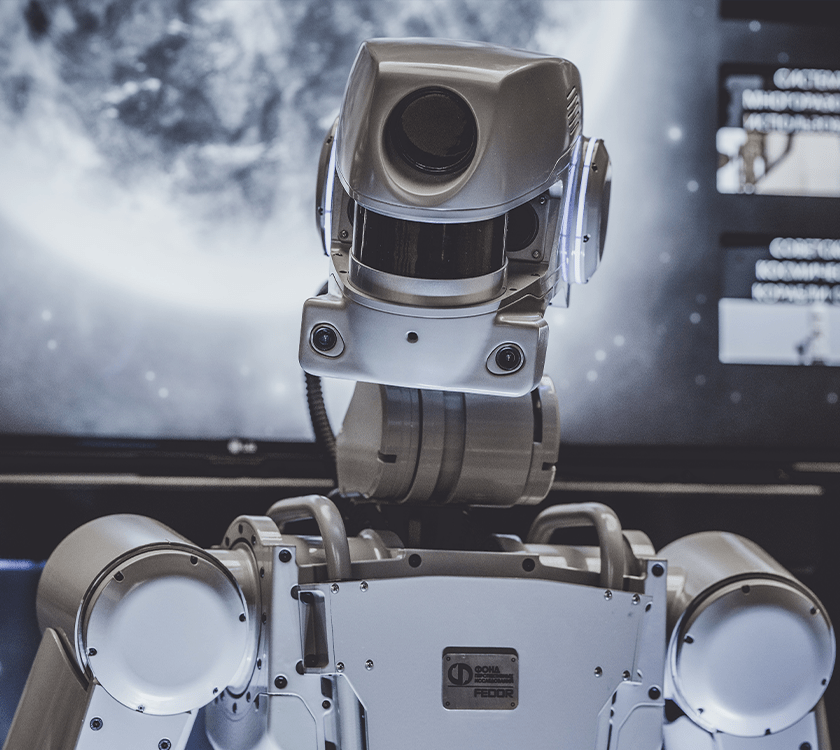

Sztuczna inteligencja (AI) to dziedzina informatyki, która rozwija się coraz bardziej i wchodzi w nasze życie. AI wykorzystuje algorytmy uczenia maszynowego i przetwarzania języka naturalnego. Pomaga to nam w wykonywaniu różnych zadań i ułatwia życie.

Jednak, wraz z postępem technologicznym i coraz bardziej zaawansowanymi systemami AI, pojawiają się również nowe pytania i wyzwania etyczne. Jakie są ograniczenia etyczne dla sztucznej inteligencji? W tym artykule postaramy się na nie odpowiedzieć.

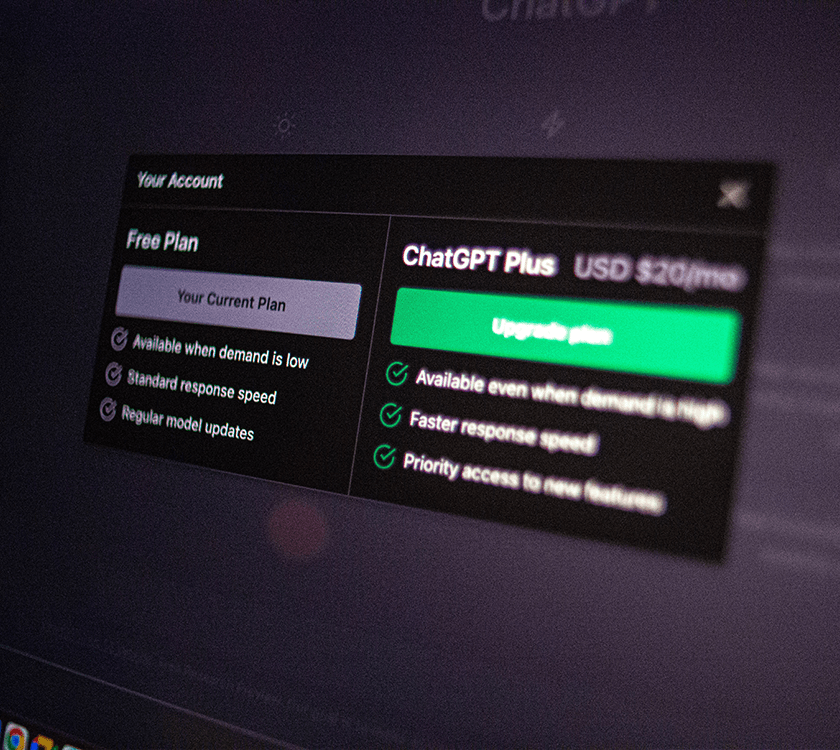

Bezpieczeństwo i prywatność danych

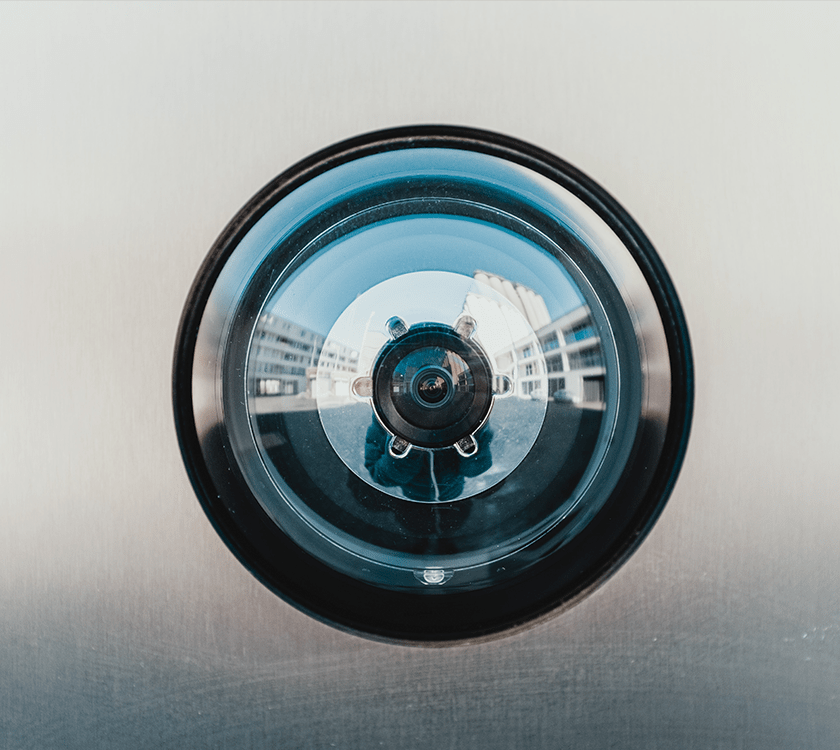

Jednym z głównych wyzwań etycznych związanych z AI jest bezpieczeństwo i prywatność danych. Wraz z coraz większą ilością danych, które są zbierane i przetwarzane przez systemy AI, pojawiają się obawy dotyczące ochrony prywatności i bezpieczeństwa tych danych.

Wydaje się, że jednym z największych zagrożeń dla bezpieczeństwa i prywatności danych są cyberprzestępcy. Cyberprzestępcy mogą wykorzystać słabości w systemach AI, aby uzyskać dostęp do prywatnych informacji i wykorzystać je w niecnych celach.

W kontekście bezpieczeństwa i prywatności danych, sztuczna inteligencja staje się coraz bardziej skomplikowana i może powodować wiele problemów, jeśli nie zostanie odpowiednio zaprojektowana i zabezpieczona. Sztuczna inteligencja opiera się na danych, które są przetwarzane w celu wykonywania określonych zadań i uczenia się. Jednak dane te mogą zawierać wrażliwe informacje, takie jak dane osobowe czy dane medyczne.

Ważne jest, aby twórcy systemów AI opracowali odpowiednie zabezpieczenia, aby chronić prywatność użytkowników oraz zapobiec przeciekom danych. Wiele naruszeń prywatności danych związanych z sztuczną inteligencją wynika z błędów w procesie uczenia maszynowego, co może prowadzić do poważnych konsekwencji dla użytkowników

Aspekty bezpieczeństwa i prywatności danych w sztucznej inteligencji są ważne i wymagają uwagi twórców oraz odpowiednich regulacji i standardów

Decyzje autonomiczne sztucznej intelidencji

Kolejnym wyzwaniem etycznym dla sztucznej inteligencji są decyzje autonomiczne. Wraz z coraz bardziej zaawansowanymi systemami AI, maszyny mogą podejmować decyzje autonomiczne, bez potrzeby udziału człowieka.

Jednak, w przypadku poważnych decyzji, takich jak decyzje medyczne czy decyzje związane z życiem i śmiercią, istnieje pytanie, czy maszyny powinny być w stanie podejmować takie decyzje bez udziału człowieka?

Musimy zwrócić uwagę na decyzje autonomiczne w kontekście sztucznej inteligencji, ponieważ są one jednym z najważniejszych aspektów. Autonomiczne maszyny mogą podejmować coraz bardziej skomplikowane decyzje, ale w przypadku decyzji medycznych, takich jak diagnozowanie chorób, dobieranie leków, czy decyzji związanych z życiem i śmiercią, np. leczenie chorób terminalnych czy zabiegi chirurgiczne, powoduje to poważne obawy.

Analiza

Chociaż systemy AI są w stanie analizować duże ilości danych medycznych szybciej i bardziej precyzyjnie niż człowiek, istnieje ryzyko, że podejmą one niesprawiedliwe lub szkodliwe dla pacjenta decyzje, ponieważ nie uwzględniają czynników, takich jak wartości etyczne, moralne czy osobiste preferencje pacjenta.

W celu zapewnienia właściwych decyzji autonomicznych, konieczne jest zapewnienie, że systemy AI są w pełni zgodne z wartościami etycznymi i moralnymi oraz monitorowanie decyzji przez ludzi, którzy mogą ocenić ich właściwość i korygować je w razie potrzeby.

Decyzje sztucznej inteligencji

W przypadku decyzji związanych z życiem i śmiercią, ryzyko błędów podejmowania decyzji przez maszyny może mieć katastrofalne konsekwencje, dlatego konieczne jest, aby decyzje te były podejmowane przez ludzi z uwzględnieniem wartości pacjenta.

Medycyna, a sztuczna inteligencja

W przypadku decyzji medycznych, maszyny mogą wykorzystywać duże ilości danych medycznych i analizować je w sposób szybszy i bardziej precyzyjny niż człowiek. Jednak, nawet jeśli system AI byłby bardzo precyzyjny, istnieje ryzyko, że podejmie on decyzje niesprawiedliwe lub szkodliwe dla pacjenta. Na przykład, decyzja o odrzuceniu lub przyjęciu pacjenta do programu leczenia może opierać się na czynnikach, które nie są objęte analizą przez AI, takich jak wartości etyczne, moralne czy osobiste preferencje pacjenta.

W przypadku decyzji związanych z życiem i śmiercią, takich jak wykonywanie zabiegów chirurgicznych lub podtrzymywanie pacjenta przy życiu przy użyciu sztucznej wentylacji płucnej, ryzyko błędów podejmowania decyzji przez maszyny może mieć katastrofalne konsekwencje. Chociaż systemy AI mogą wykazywać bardzo wysoką dokładność, nie są one w stanie uwzględnić wszystkich czynników, takich jak wartości etyczne, kulturowe czy religijne, które są ważne dla pacjenta i jego rodziny.

Właściwe decyzje

W przypadku decyzji związanych z życiem i śmiercią, takich jak wykonywanie zabiegów chirurgicznych lub podtrzymywanie pacjenta przy życiu przy użyciu sztucznej wentylacji płucnej, ryzyko błędów podejmowania decyzji przez maszyny może mieć katastrofalne konsekwencje. Chociaż systemy AI mogą wykazywać bardzo wysoką dokładność, nie są one w stanie uwzględnić wszystkich czynników, takich jak wartości etyczne, kulturowe czy religijne, które są ważne dla pacjenta i jego rodziny.

Podsumowanie

Aby zapewnić przestrzeganie wartości społecznych w użytkowaniu sztucznej inteligencji, ludzie muszą wprowadzić odpowiednie regulacje i standardy dotyczące bezpieczeństwa i prywatności danych, eliminacji dyskryminacji oraz przejrzystości i zrozumiałości procesów decyzyjnych w systemach AI. Sztuczna inteligencja przynosi wiele korzyści, ale także stawia przed nami wiele wyzwań etycznych, które musimy rozwiązać.

Wprowadzenie odpowiednich regulacji i standardów dotyczących bezpieczeństwa i prywatności danych, eliminacji dyskryminacji oraz przejrzystości i zrozumiałości procesów decyzyjnych w systemach sztucznej inteligencji jest kluczowe, aby zapewnić, że AI będzie używane w sposób etyczny i zgodny z wartościami społecznymi. W ten sposób sztuczna inteligencja może przynieść wiele korzyści dla ludzkości, jednocześnie zachowując szacunek dla prywatności, bezpieczeństwa i równości.